5.3.3 일반화선형모형 ~ 5.4 분류 모델 평가하기

5.3.6 선형회귀와 로지스틱 회귀의 유사점과 차이점

모델을 피팅하는 방식(최소제곱법을 사용할 수 없다)

모델에서 잔차의 측징과 분석

1) 모델피팅

보통 선형회귀에서는 모델피팅을 위해 최소제곱법을 사용

그러나 로지스틱 회귀에서는 최대우도추정(maximum likelihood estimation : MLE) 사용하여 모델일 피팅

> 우리가 보고 있는 데이터를 생성했을 가능성이 가장 큰 모델을 찾는 것

로지스틱 회귀에서 종속변수는 0과 1이 아니라 응답이 1인 로즈 오즈비의 추정치이다

> MLE는 예쌍 로그 오즈비가 관찰된 결과를 가장 잘 설명하는 모델을 찾는 것

최소제곱법 : 회귀모형과 데이터간 차이(잔차)의제곱을 계산하여 최솟값이 되는 파라미터를 구하는 것

주요개념

로지스틱 회귀는 출력이 이진변수라는 점만 빼면 선형회귀와 매우 비슷하다

선형모형과 비슷한 형태의 모델을 만들기 위해, 응답변수(y)로 오즈비의 로그값을 사용하는 등의 몇가지 변환이 필요하다

반복과정을 통해 선형모형을 피팅하고 나면, 로그 오즈비는 다시 확률값으로 변환된다

로지스틱 회귀는 계산속도가 빠르고 새로운 데이터에 대해서도 간단한 산술연산으로 빠르게 결과를 구할 수 있다는 장점때문에 많이 사용된다

5.4 분류모델 평가하기

용어정리

정확도 : 정확히 분류된 비율

혼돈행렬 confusion matrix :분류에서 예측된 결과와 실제 결과에 대한 레코드의 개수를 표시한 테이블

민감도 : 1을 정확히 1로 분류한 비율(재현율)

특이도 : 0을 정확히 0으로 분류한 비율

정밀도 : 1이라고 예측한 것들 중에 1이 맞는 경우의 비율

ROC 곡선: 민감도와 특이성을 표시한 그림

리프트 : 모델이 다른 활률 컷오프에 대해 1을 얼마나 더 효과적으로 구분하는지 나타내는 측정 지표

분류 성능을 측정하는 가장 간단한 방법은

정확히 예측한 것들의 비율(정확도)가 얼마인지 보는 것

(1) 혼돈행렬

(2) 정밀도, 재현율, 특이도

정밀도 : 예측된 양성 결과의 정확도, 참양성 / 예측양성(참양성 + 거짓양성)

재현율(민감도) : 양성결과를 예측하는 모델평가, 참양성/ 양성데이터(참양성 + 거짓음성)

> 실제 양성을 옳게 판단한 비율

특이도 : 음성결과 예측평가 , 참/ 음성데이터 (참음성 + 거짓양성)

> 실제 음성을 옳게 판단한 비율

cutoff(threshold) : 분류기준으로 1로 판단할 확률 (보통 0.5)

> 양성을 얼마나 확신해야 양성으로 분류할 것인가

정밀도가 크다는 것은 실제 양성만 양성이라고 예측한 것

(예 : 정말 암환자인 사람만 암환자라고 예측 : 애매모호한 암환자는 배제됨)

> cutoff가 높아지면 정밀도( 참양성 / 참양성 + 거짓양성⬇️ )가 높아진다

재현율을 높이면 실제 양성이 아니어도 양성으로 예측한다

(예: 정말 암환자가 아니어도 암환자라고 예측

> 조금이라도 암환자일것 같으면 전부 암환자라고 분류 : 실제 음성인 사람도 포함됨)

> cutoff가 낮아지면 재현율( 참양성/ 참양성 + 거짓음성⬇️)가 높아진다

정밀도를 유지하는 상황에서 재현율을 높이는 게 좋다!

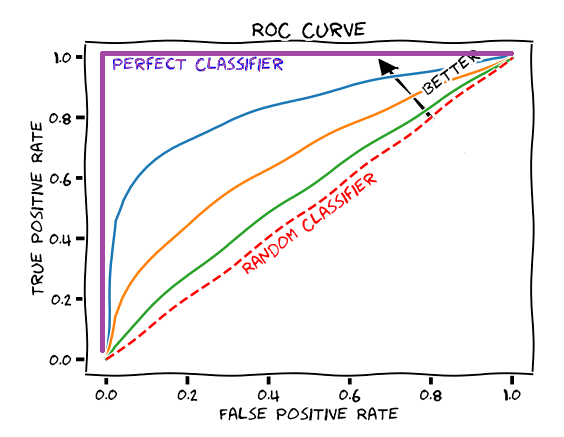

(3)ROC곡선

재현율과 특이도 사이는 트레이드 오프 관계

> 양성을 잘 잡아낸다는 것은 그만큼 음성을 양성으로 잘못 예측할 가능성도 높아지는 것

ROC곡선 : 재현율과 특이도 사이관계를 표현하는 지표

던, 분류기 성능에 대한 값은 알 수 없음

(4) AUC

ROC곡선의 아래쪽 면적,

AUC값이 높을수록 더 좋은 분류기

AUC값 1 = 0을 1로 잘못 예측하는 경우 없이 1을 정확하게 분류한 것

> AUC를 사용하면 단순히 정확도만을 사용하는 것보다 더 좋은 결과를 얻을 수 있음

> 전체적인 정확도를 높이면서 실무에서 중요한 1을

더 정확히 분류해야 하는 트레이드오프를 얼마나 잘 처리하는지 평가할 수 있음

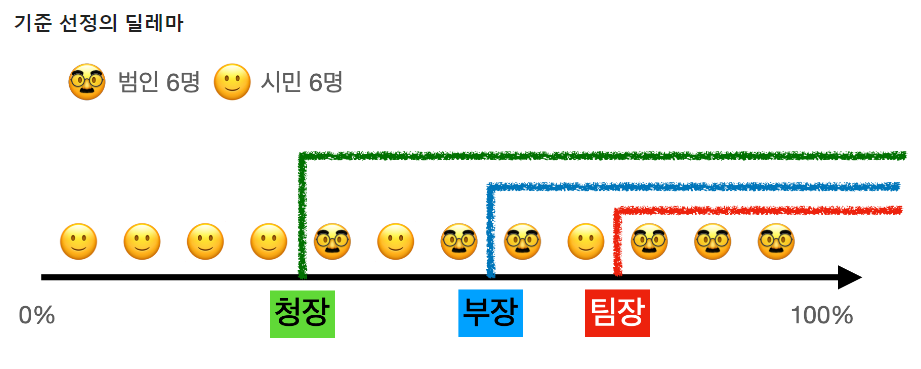

컷오프 : 팀장 > 부장 > 청장

컷오프(분류기준)가 높을수록 확실한 범인만 찾아(범인으로 오해한 시민이 없음) 범인을 놓침

컷오프가 낮을수록 광범위하게 범인을 찾아(모든 범인 발견) 시민을 범인이라고 오해를 받음

재현율 = True positive

참양성/ 양성데이터(참양성 + 거짓음성)

1 - 특이도 = False Positive

특이도 : 음성결과 예측평가 , 참음성/ 음성데이터 (참음성 + 거짓양성)

False Positive : 실제 음성인 값중에 양성으로 잘못 한단한 비율

|

|

| https://yangoos.tistory.com/2 | https://aimb.tistory.com/144 |

컷오프 100일 경우 재현율, 거짓양성비율(1-특이도) 모두 0 > 그 누구도 범인으로 판단할 수 없음

컷오프가 낮아질수록(범인을 확신하는 기준이 낮아질수록)

재현율 1, 거짓양성비율 모두 1 > 모든 사람을 범인이라고 판단 : 범인을 잡았지만 시민도 다잡음

*f1score : 재현율과 정밀도의 조화평균

> 조화평균으로 하는 이유는, 분균형한 지표 사이에서 큰 값에 패널티를 주어

작은 값에 불리하지 않도록 하기 위함

> 재현율과 정밀도 값이 균일하지 않아도 조화로운 평균을 구할 수 있음

참고

threshold, precision, recall의 의미

머신러닝에서 어떤 모델이 더 예측을 잘하는가 판단하기 위해 여러 평가지표를 사용한다. Accuracy(정확도)는 전체 범주를 모두 바르게 맞춘 경우 / 전체 수 = tp+tn/total f1 점수는 precision과 recall의

aimb.tistory.com

ROC Curve와 Precision-Recall Curve 해석

글의 방향 ROC Curve와 Precision-Recall Curve는 classification 모델의 성능을 파악하기 위해 활용됩니다. 일반적으로는 모델 성능을 파악하는 방법으로 예측 정확도(Accuracy)를 활용합니다. 10건 중 8건의 테

yangoos.tistory.com

'학습노트 > 통계' 카테고리의 다른 글

| [통계학습] 통계적 머신러닝(2) (0) | 2024.06.24 |

|---|---|

| 분류(3) ~ 통계적 머신러닝(1) (0) | 2024.06.17 |

| [통계학습] 분류 (1) (1) | 2024.06.10 |

| [통계학습] 회귀와 예측(2) (2) | 2024.06.05 |

| [통계학습] 회귀와 예측(1) (1) | 2024.06.03 |